AI w chmurze vs lokalne AI – na czym polega różnica?

Większość z nas, myśląc o sztucznej inteligencji, ma przed oczami narzędzia takie jak ChatGPT, Claude czy Google Gemini. To rozwiązania rewolucyjne, jednak działają w modelu usługi (SaaS) – korzystając z nich, de faAI w chmurze vs lokalne AI – na czym polega różnica?

Spis treści

- AI w chmurze vs lokalne AI – na czym polega różnica?

- Dlaczego warto uruchomić lokalne AI?

- Pełna prywatność danych

- Działanie offline

- Brak abonamentu

- Mniej ograniczeń

- Czym jest LM Studio?

- Najważniejsze zalety LM Studio

- Wymagania sprzętowe dla lokalnego AI

- Jak zainstalować LM Studio na Windows?

- Instalacja LM Studio na Linux

- Część 3: Pierwsze kroki i pobranie modelu

- 1. Wyszukiwanie modelu

- 2. Wybór wersji (Kwantyzacja)

- 3. Rozmowa (Chat)

- Porada dla wydajności: Akceleracja GPU

- Podsumowanie

Większość z nas, myśląc o sztucznej inteligencji, kojarzy narzędzia takie jak ChatGPT, Claude czy Google Gemini. To rozwiązania potężne i wygodne, jednak działają w modelu usługi (SaaS). Oznacza to, że korzystając z nich, w praktyce „wynajmujemy” sztuczną inteligencję od dużych korporacji.

Każde pytanie trafia na zdalne serwery, a odpowiedzi są generowane w chmurze. Często wiąże się to z ograniczeniami funkcjonalnymi, limitami zapytań lub koniecznością wykupienia miesięcznego abonamentu.

Alternatywą dla AI w chmurze jest lokalne AI, czyli uruchamianie modeli językowych bezpośrednio na własnym komputerze. I właśnie tutaj pojawia się LM Studio.

Dlaczego warto uruchomić lokalne AI?

Pełna prywatność danych

Największą zaletą lokalnego AI jest prywatność. Dane nigdy nie opuszczają Twojego komputera. Możesz bez obaw analizować poufne dokumenty, kod źródłowy, prywatne e‑maile czy notatki, mając pewność, że nie trafią one na serwery Big Techu ani nie zostaną użyte do trenowania kolejnych modeli.

Działanie offline

Lokalne AI działa bez dostępu do internetu. Brak sieci w podróży, awaria usług chmurowych czy ograniczenia regionalne nie mają znaczenia — model działa zawsze tam, gdzie jest Twój komputer.

Brak abonamentu

Większość modeli językowych (np. od Meta, Mistral AI czy społeczności open source) jest darmowa. Korzystając z LM Studio, nie płacisz za plany „Plus” ani „Pro”.

Mniej ograniczeń

Modele lokalne zwykle nie posiadają tak restrykcyjnych filtrów i blokad tematycznych jak rozwiązania korporacyjne, co pozwala na bardziej swobodną i naturalną pracę z AI.

Czym jest LM Studio?

Jeszcze kilka lat temu uruchomienie modelu językowego na domowym komputerze wymagało znajomości Pythona, instalowania bibliotek i korzystania z terminala. Dla większości użytkowników była to bariera nie do przejścia.

LM Studio całkowicie to zmienia. Jest to nowoczesna aplikacja desktopowa, którą można określić jako „przeglądarkę dla modeli AI”. Oferuje graficzny interfejs przypominający ChatGPT i przejmuje całą techniczną złożoność działania modeli.

Najważniejsze zalety LM Studio

- Brak kodowania – nie musisz pisać ani jednej linijki kodu

- Wbudowana wyszukiwarka modeli z repozytorium Hugging Face

- Obsługa formatu GGUF, zoptymalizowanego pod działanie na PC i laptopach

- Wsparcie dla GPU i CPU, w tym GPU Offloading

Wymagania sprzętowe dla lokalnego AI

Zanim zaczniesz, upewnij się, że Twój komputer poradzi sobie z obsługą AI. W przypadku lokalnych modeli, zasada jest prosta: więcej pamięci = lepszy/mądrzejszy model.

- Procesor (CPU):

Musi obsługiwać instrukcje AVX2. Posiada je większość procesorów nowszych niż 10 lat (np. Intel Core 4-tej generacji i nowsze, AMD Ryzen).

Można uruchamiać modele na samym procesorze, ale działają one wtedy znacznie wolniej. - RAM (Pamięć systemowa):

- 8 GB: Absolutne minimum (uruchomisz tylko bardzo małe, szybkie modele).

- 16 GB – 32 GB: Wartość zalecana. Pozwala na systemowi “oddech”, gdy model zajmie dużą część zasobów.

- Karta Graficzna (GPU) i pamięć VRAM – NAJWAŻNIEJSZE:

Do sprawnego działania najlepiej używać kart NVIDIA (technologia CUDA). Karty AMD lub Apple Silicon (Mac M1/M2/M3) również działają, ale wydajność zależy tu głównie od ilości pamięci VRAM. Modele AI muszą się w niej “zmieścić”, by działać błyskawicznie.Ile VRAM potrzebujesz?- 4 GB – 6 GB VRAM: Minimum socjalne. Uruchomisz małe, skompresowane modele (np. Microsoft Phi-3, Gemma 2B lub bardzo mocno skompresowane wersje Llama 3 8B).

- 8 GB VRAM: “Złoty środek” na start. Pozwala wygodnie uruchamiać najpopularniejsze modele w rozmiarze 7-8 miliardów parametrów (np. Llama 3, Mistral) z dobrą prędkością.

- 12 GB – 16 GB VRAM: Poziom entuzjasty. Pozwala na uruchamianie większych modeli (13B-14B) lub modeli standardowych z bardzo długą pamięcią kontekstową (AI pamięta więcej z rozmowy).

- 24 GB VRAM (np. RTX 3090/4090): Pozwala na uruchamianie potężnych modeli (30B-70B parametrów), które jakością zbliżają się do GPT-4.

Jak zainstalować LM Studio na Windows?

Instalacja na Windowsie jest banalnie prosta i przypomina instalację typowego programu biurowego.

- Pobierz instalator:

Wejdź na oficjalną stronę: lmstudio.ai.

Kliknij duży niebieski przycisk: “Download LM Studio for Windows”. - Uruchom plik:

Otwórz pobrany plik (zazwyczaj nazwany np. LM-Studio-0.3.x-Setup.exe). - Proces instalacji:

LM Studio na Windows instaluje się zazwyczaj automatycznie do folderu użytkownika (AppData). Nie ma tu skomplikowanego kreatora – po chwili zobaczysz skrót na pulpicie lub program uruchomi się samoczynnie. - Gotowe! Możesz przejść do sekcji “Pierwsze Kroki”.

Instalacja LM Studio na Linux

Wersja na Linuxa jest obecnie dystrybuowana głównie jako plik AppImage.

Co to jest AppImage? To format typu “wszystko w jednym” (odpowiednik wersji Portable na Windows). Program zawiera już w sobie wszystkie biblioteki, więc działa na każdej dystrybucji (Ubuntu, Fedora, Mint) bez konieczności instalowania go w systemie.

- Pobierz AppImage:

Wejdź na stronę lmstudio.ai i kliknij “Download LM Studio for Linux”. - Przygotowanie pliku:

Pobrany plik będzie miał rozszerzenie .AppImage. Zanim go uruchomisz, musisz nadać mu prawa do wykonywania.- Metoda graficzna: Kliknij prawym przyciskiem myszy na plik -> Właściwości (Properties) -> zakładka Uprawnienia (Permissions) -> zaznacz “Zezwól na wykonywanie pliku jako programu” (Allow executing file as program).

- Metoda terminalowa (szybsza):

Otwórz terminal w folderze z pobranym plikiem i wpisz:

chmod +x LM_Studio-*.AppImage3. Uruchomienie:

Teraz wystarczy dwukrotnie kliknąć w plik lub wpisać w terminalu ./LM_Studio-*.AppImage.Dla zaawansowanych: Warto utworzyć sobie alias w .bashrc lub plik .desktop, aby uruchamiać program z menu aplikacji systemowych, ale do testów wystarczy proste uruchomienie pliku.

Część 3: Pierwsze kroki i pobranie modelu

Po uruchomieniu programu zobaczysz nowoczesny, ciemny interfejs. Oto jak zacząć rozmowę z AI:

1. Wyszukiwanie modelu

Kliknij ikonę lupy w menu po lewej stronie. W pasku wyszukiwania wpisz nazwę modelu. Polecane na start:

- Llama 3 (świetny model od Meta)

- Mistral (dobry, szybki model)

- Bielik (model dobrze radzący sobie z językiem polskim)

2. Wybór wersji (Kwantyzacja)

Po lewej zobaczysz listę modeli. Kliknij na wybrany. Po prawej zobaczysz listę plików do pobrania. Zobaczysz tam oznaczenia typu Q4_K_M, Q8_0 itp.

- Co to znaczy? To poziom kompresji (kwantyzacji).

- Co wybrać? Najlepszy balans to zazwyczaj Q4_K_M lub Q5_K_M. Oferują dobrą jakość przy rozsądnym zużyciu pamięci.

- Kliknij przycisk Download. Pasek postępu pokaże pobieranie (pliki mają zazwyczaj od 4GB do 10GB).

3. Rozmowa (Chat)

Po pobraniu kliknij ikonę “dymku” (AI Chat) w lewym menu.

- Na górze, na środku ekranu, wybierz z listy pobrany przed chwilą model.

- Gdy pojawi się pasek (model załadowany do RAMu), możesz pisać w dolnym oknie, tak jak w ChatGPT.

Porada dla wydajności: Akceleracja GPU

To najważniejszy punkt, jeśli chcesz, aby AI odpowiadało szybko, a nie “dukało” słowo po słowie.

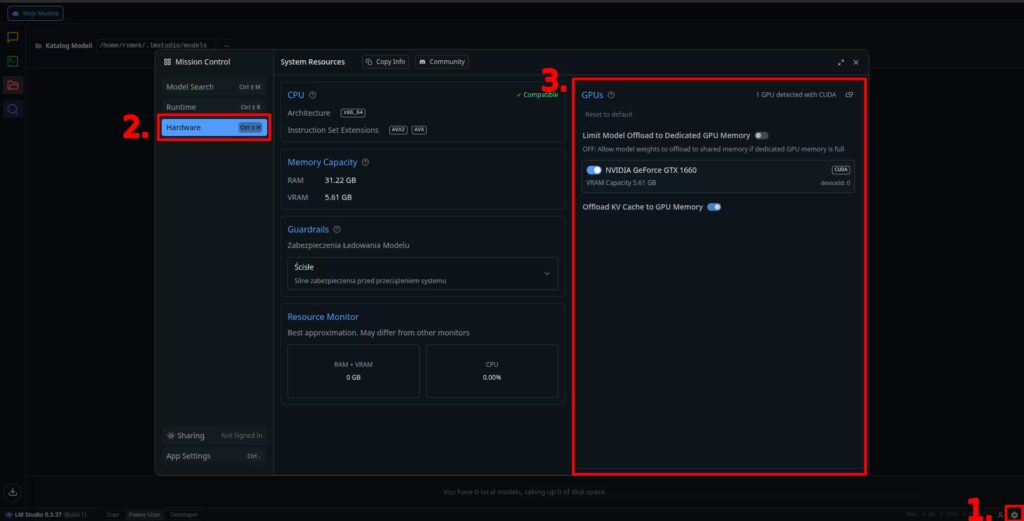

- Kliknij ikonę Ustawień (zębatkę) znajdującą się w prawym dolnym rogu ekranu.

- W oknie Mission Control wybierz po lewej stronie zakładkę Hardware (lub użyj skrótu Ctrl+Shift+H).

- W panelu po prawej znajdź sekcję GPUs.

- Upewnij się, że przełącznik przy Twojej karcie graficznej (np. NVIDIA GeForce GTX 1660) jest włączony (świeci na niebiesko).

- Włącz również opcję “Offload KV Cache to GPU Memory”, aby przenieść pamięć podręczną modelu do karty graficznej, co dodatkowo przyspieszy działanie.

Podsumowanie

LM Studio to jedno z najlepszych narzędzi do rozpoczęcia pracy z lokalnym AI. Oferuje pełną prywatność, brak abonamentów, działanie offline i ogromną elastyczność. Jeśli chcesz uniezależnić się od chmurowych usług AI i mieć pełną kontrolę nad danymi, LM Studio jest doskonałym wyborem.

No Comment! Be the first one.